大模型的爆發式發展正將算力推至數字經濟的核心戰略地位���。GPT-4o與DeepSeek-R1等模型的多模態突破�,不僅標志著AI進入"參數爆炸"時代(GPT-4單次訓練需2.15×10^25 FLOPs�,等同3萬臺A100全年運轉)�,更暴露出算力供需的尖銳矛盾——據智源研究院的報告預估國內大模型訓練算力缺口已達109EFLOPS(約20個太湖之光年產能)���。在新技術廣泛應用和全球算力短缺的背景下�,信創國產化率要求倒逼華為昇騰����、海光DCU等替代方案落地�����。芯片類型��、架構和供應商方面都呈現出多元化的趨勢�。

根據中國信通院《數據中心算力技術圖譜(2023)》及IDC《全球異構計算白皮書》�����,異構算力可分為以下幾大層級:

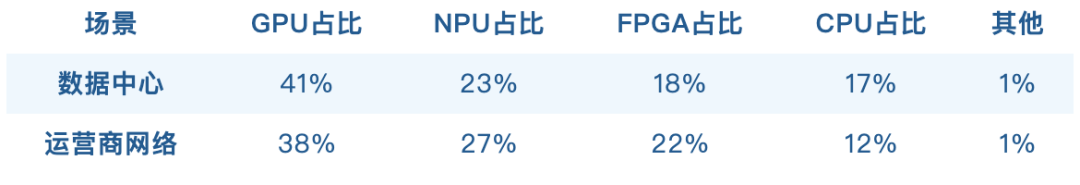

根信通院公布數據顯示���,算力主要集中在數據中心��、運營商網格�。在這兩大主力中存在明顯的算力異構分布����,運營具體情況如下:

從上信通院發表文章和數字中國萬里行的洞察中發現��,國內數據中心�����、運營商等均存在多元異構算力���。但多元算力的開發生態體系相對獨立�,無標準和統一規范�,應用的跨架構開發和遷移困難�,亟需通過開源�����、開放的方式建立可屏蔽底層硬件差異的統一異構開發平臺��。

從東數西算下新型算力基礎設施發展白皮書整理和業務場景梳理�,我們發現異構算力管理和調度存在以下核心的難點問題:

硬件多樣性與兼容性問題:數據中心采用多種硬件設備(如 CPU���、GPU���、NPU�����、TPU 等)��,不同架構的硬件設備(如 x86��、ARM 等)難以兼容��,不同的硬件底座具備的算力發現和監控方法不一致�,導致管理和調度復雜����;

算力服務的標準化與規范化不足:目前的算力接口較為復雜��,缺乏統一的標準和規范�����,導致算力資源的輸出和服務質量參差不齊���,業務跨架構遷移難度大�,無法有效在異構算力資源上進行調度�,跨架構任務遷移成本激增(某金融云平臺改造耗時6個月)��,算法研發周期被非必要工程化拖累�����;

算力調度接口不一致���,資源錯配導致的資源浪費:不同算力的調度接口不一致��,錯誤的調度方式無法使用資源�����,導致混合架構的集群資源閑置�;

異構架構依賴的技術棧不同����,對人力技術要求大���,導致異構接入難���,新硬件資源難快速賦能業務����,需要龐大的生態支撐���,推廣難����。

在面對以上異構算力管理和調度的難點和問題�����,我們探索了更優的異構資源的管理和調度解決方案�����。旨在提高資源利用率和管理效率���。本方案通過三個關鍵層次實現對異構資源的有效管理和高效調度��。

首先����,在底層異構納管層��,我們實現了對多種硬件(如CPU�、GPU��、FPGA等)的適配����,確保系統的算力發現和資源監控功能能夠精準識別并管理所有可用計算資源���。這不僅為后續的資源分配提供了堅實的基礎���,還極大地增強了系統對不同硬件平臺的支持能力���。

其次����,在調度層�,我們開發了一款統一的異構調度工具�,該工具通過一個統一調度接口將各類異構算力整合起來�����,顯著降低了資源調度的復雜度�����。同時����,利用先進的協同技術和精細化調度算法��,我們在多維度上提升了資源的使用效率����,實現了負載均衡和動態資源調整����,從而提高了服務響應速度和服務質量���。

最后�,在異構適配層���,我們針對常用模型進行了定向適配���,并提供了強大的模型轉換工具��,大幅簡化了業務遷移過程中的兼容性問題����。這些措施不僅減少了遷移成本����,還加快了新應用的部署速度�,使得企業能夠更快地適應市場變化和技術更新�����。整體方案架構如下:

針對異構資源統一管理和運維�����,主要圍繞異構資源的接入���、算力發現和算力使用情況的監控三個維度展開�����,特別強調在異地資源納管策略時需要重點考慮主機之間的帶寬情況����。

首先在異地資源納管策略層面會考慮主機之間的帶寬清單���,當異構資源在同一機房或者帶寬較大的網絡里面�,低延遲和高帶寬有助于更高效的數據傳輸和任務調度��。這種情況一般會考慮一個集群納管�����,這樣節省管理節點的資源消耗��,如果時高可用部署方式需要3個管理節點����,如兩種異構統一到一個集群管理則可以節省3個管理節點的資源消耗����。

異構資源統一納管���,利用Kubernetes插件擴展機制來對接異構底層算力發現��。通過擴展插件����,系統可以識別并管理異構硬件GPU資源�����。通過插件適配系統具備自動掃描網絡中所有連接的計算設備的能力��,識別其類型�����、型號及性能參數(如核心數����、頻率�����、內存大小等)����。通過算力發現機制將新接入的硬件設備將被自動注冊到系統中��,降低人工信息填寫錯誤導致的調度偏差�。

在資源管理層面利用算力專用的監控代理��,實時采集硬件設備的運行數據�,如CPU使用率��、內存使用率��、顯存使用量和算力使用量等參數�,確保數據的準確性和及時性�����,幫助算力正常調度�����。將采集的監控數據在一個平臺展示���,助力管理員從多維度查看平臺資源使用狀況�,更清晰地了解平臺資源運維問題����,從而指導管理員進行資源規劃調整����,有效避免因分配不當而引發的資源過載和閑置現象�����。

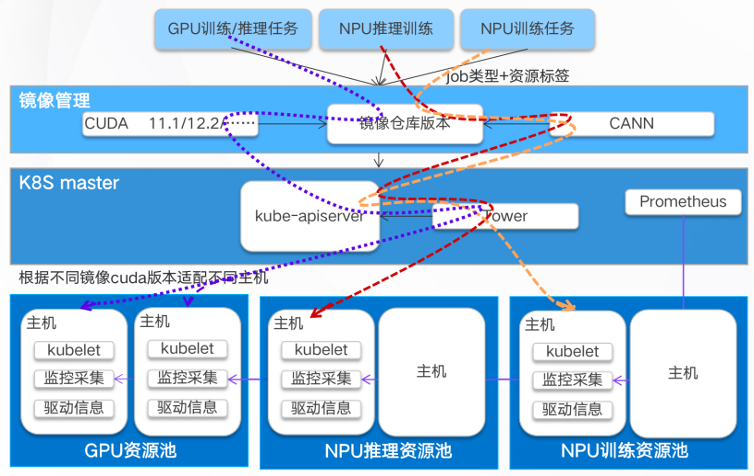

AI模型運行環境與底層驅動之間存在依賴關系����,不適配的資源會致使模型運行出現故障����。為降低因錯誤調度引發的資源浪費和部署困難的問題�,平臺對任務類別���、模型運行環境依賴�����、硬件依賴等信息加以管理����,以保障任務能夠正常使用資源�。

那么平臺底層是如何調度的呢�?首先為資源主機添加標簽����,標簽信息涵蓋:芯片型號�����、網絡特性����、驅動版本等�。其次對模型運行環境依賴進行管理�����,如 CUDA/CANN/PyTorch 版本等信息����。平臺內部維護一套任務�����、環境依賴與驅動版本的適配關系表����。當平臺部署模型時��,在指定模型鏡像和資源規格后�,系統會自動獲取依賴信息���,并得到該模型需要的部署資源標簽�,調度器依據標簽進行調度�����。通過上述過程�,即可實現芯片硬軟件的智能適配��,通過自動調度減少因錯誤指令啟動不合符任務需求的算力導致的資源浪費��。具體的自動適配流程示意如下�����。

每種芯片均具備其獨有的編程接口與使用規范���,開發者在運用資源時��,必須針對每一種芯片類型予以適配��。如此一來�����,不僅加大了開發的難度���,還延長了開發的周期�����。伴隨芯片技術的持續發展�����,新的接口與功能不斷涌現�,開發者需要不斷追蹤并適應這些變化�����,這會耗費大量的人力和時間����。為應對上述挑戰�����,對接入的異構資源進行統一適配����,構建形成標準服務 API�����,其設計如下:

1)提供標準統一API�����,將硬件類型作為輸入參數中的一部分�����,底層獲取API中的硬件信息并自動調度到匹配硬件��,這樣屏蔽了底層硬件接口差異�,業務側在調用時無需關注具體的硬件調度����,僅需關注需要的硬件設備即可����。

2)指定標準的資源配額信息����,通過指定芯片類型和配額信息作為調度參數傳入標準API��,由平臺依據參數智能調度最為適宜的計算資源�。這一設計使業務開發者只需適配一次API���,便能調用多種算力資源�。

為了業務更好的使用異構算力�����,能達到快速遷移的目標�,智算平臺針對當前主流模型(如qwen�����、LLama���、deepseek����、 ResNet�����、BERT����、YOLO 等)進行定向適配���,從模型運行環境構建�、模型文件轉換���、推理服務部署到模型的微調訓練進行各種硬件的適配�����,形成開箱即用的工具���,用戶即可通過頁面的配置����,實現對這些適配過模型的使用��,單次模型適配的投入即可實現多用戶的賦能���。

同時在算子層����,集成各異構算力的轉換工具�,支持用戶使用工具快速轉換出自定義模型的格式�,實現異構算力的快速遷移���。

通過部署異構納管調度解決方案����,我們實現了顯著的運營優化和效能提升����,具體表現在以下幾個方面:

1)運維成本與復雜度大幅削減:構建統一管理平臺���,一個界面可查看分布在11個不同地市的資源監控情況����。這極大地簡化了運維流程���,通過集中化管理減少了運維工作量�,從而有效降低了總體運維成本�����。

2)資源調度可靠性增強:借助硬軟件智能適配技術�,實現了更為精準����、高效的資源分配���。有效地預防了因硬軟件不兼容而引發的故障�����,確保了資源調度過程中的穩定性和可靠性����。

3)業務開發效率躍升:引入標準服務API接口����,屏蔽了底層硬件的復雜性����,使開發人員無需關心具體的算力調度�,僅適配一次API���,即可獲取所需計算資源�,大大簡化了開發流程��,縮短了產品迭代周期���。

4)模型異構適配層:我們的目標是通過針對常用模型的定向適配和提供強大的模型轉換工具����,大幅簡化業務遷移過程中的兼容性問題����。